-

AIは実証から本格運用へ

現在、AIは「PoC段階」から「本格運用フェーズ」へと移行しています。

エージェント型AI、フィジカルAI、大規模言語モデル(LLM)、そしてトークン生成型ワークロードの急増により、企業にはこれまで以上に高度でスケーラブルなAIインフラが求められています。ASUSの取り組み:

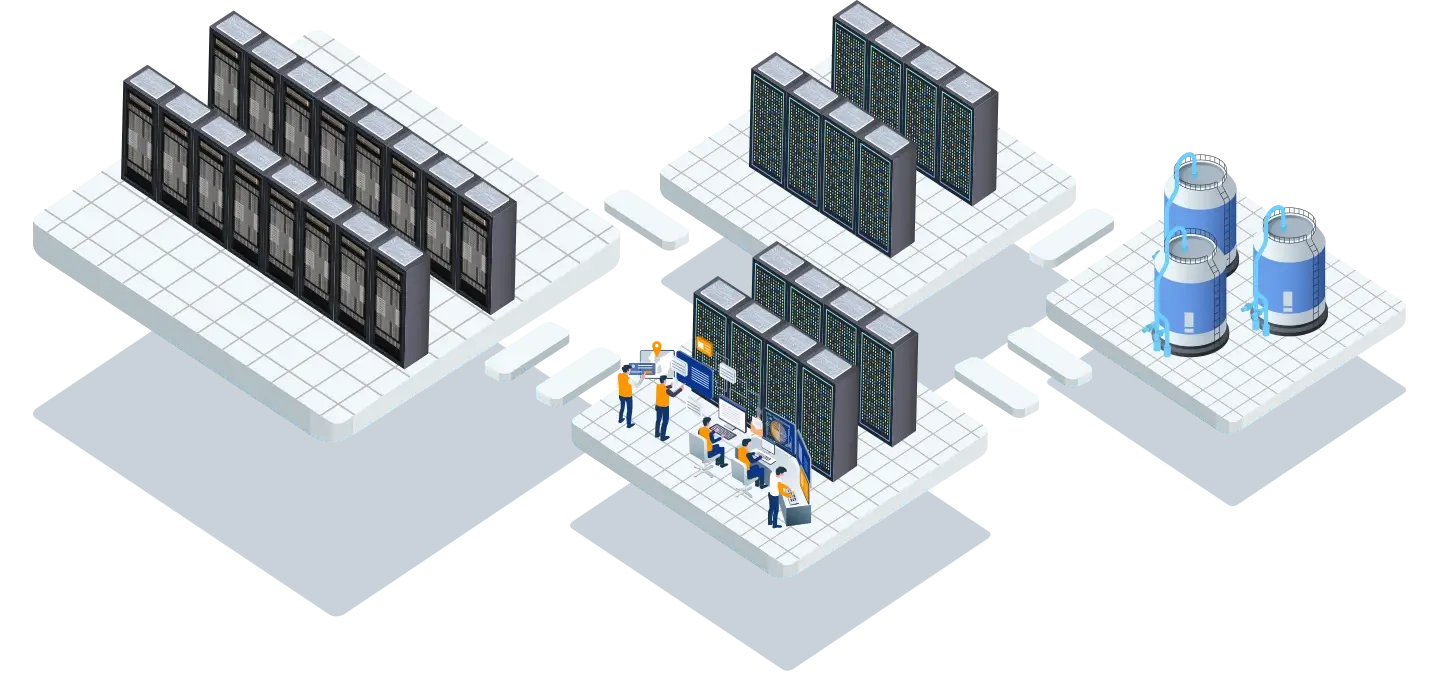

データを価値へ変える、次世代AIインフラソリューションASUS AIファクトリーは、企業が保有する膨大なデータを高度なインテリジェンスへと変換し、構想段階のアイデアを実運用可能なAIソリューションへと加速させる次世代AI基盤です。

生成AIや大規模言語モデル(LLM)が急速に進化する中、ASUSはハードウェア、ソフトウェア、ネットワーク、サービスを統合した包括的なAIソリューションを提供し、継続的な技術革新を通じてエンタープライズAIの最前線をリードしています。

デザイン思考に基づくアプローチにより、AIを企業活動のあらゆるレイヤーに組み込み、戦略立案から開発、運用までを一貫して支援。エッジ、データセンター、クラウド、オンプレミスを横断する幅広いポートフォリオによって、AIを“誰もが、どこでも活用できる”環境を実現します。

ASUSは、AIが生み出す新たな価値と可能性を、すべての業界と社会へ届けることをミッションとしています。ユビキタスAI ― どこでも活用できるAI基盤が、無限の可能性を切り開く

ASUSは、従来のPCメーカーの領域を超え、

ハードウェア・ソフトウェア・サービスを統合した包括的AIエコシステムを構築しました。

ASUS AIファクトリーの特長

- クラウド/オンプレミス両対応のハイブリッド設計

- 多様なエンタープライズAIワークロードに最適化

- 開発者、AI研究機関、製造業、金融、医療、ミッションクリティカル領域、5G、CSPまで幅広く対応

-

ASUSとNVIDIAの共同エンジニアリングにより、

トークン生成型AIファクトリー向けフルスタックソリューションを提供ASUS AIファクトリーは、ハードウェア、ソフトウェアプラットフォーム、ネットワーク、サービスをシームレスに統合した包括的なAIアーキテクチャを提供し、企業のAI導入を構想段階から本格運用まで一貫して支援します。

エッジAIからAIスーパーコンピューティングに至るまでを網羅するスケーラブルなインフラストラクチャにより、高度化・大規模化する多様なAIワークロードに柔軟かつ持続的に対応します。

さらに、AI活用の迅速化とTCO(総所有コスト)の最適化を同時に実現し、企業のAI投資対効果を最大化します。グローバルサポート体制と強固なAIガバナンス

ASUSは、世界2,200拠点以上に広がるグローバルサービスネットワークを基盤に、SLA(サービスレベル契約)に準拠した高品質なサポート体制を提供しています。設計・製造から導入、運用・保守に至るまで、製品ライフサイクル全体を包括するカスタマイズソリューションにより、企業のAI基盤を長期的かつ安定的に支援します。

さらに、強固なAIガバナンスおよびデータガバナンス体制を確立し、データ品質の維持、セキュリティ確保、各種法規制への準拠を徹底。AIが生み出す意思決定プロセスの正確性・一貫性・透明性を担保し、信頼性の高いAI運用環境を実現します。お問い合わせはこちら ▶

-

すべてのAIワークロードを支える統合インフラ基盤

ASUSは、「All-in-AI」コンセプトに基づくサーバー戦略のもと、戦略的パートナーと緊密に連携しながら、次世代AIエコシステムの進化を加速しています。

産業製造の思想に着想を得たASUS AIファクトリーのアプローチは、AI開発を属人的な取り組みから脱却させ、標準化・自動化された再現性の高いプロセスへと昇華。膨大なデータを、AI主導の高付加価値なインサイトと具体的なビジネスアクションへと体系的に変換します。NVIDIA検証済みASUS AI PODを核としたエンタープライズAIファクトリー基盤

NVIDIA により検証されたASUS AI PODを中核とするASUS AIファクトリーは、エージェントAI、フィジカルAI、HPCワークロードを、オンプレミス環境の NVIDIA Blackwell プラットフォーム上で開発・展開・運用するための実践的かつ体系化された導入モデルを提供します。

エンタープライズIT向けに設計されたこのアーキテクチャは、高性能なアクセラレーテッドコンピューティング、ネットワーキング、ストレージ、ソフトウェアを統合し、企業が AI ファクトリーを迅速に立ち上げ、価値創出までの時間を大幅に短縮するとともに、導入リスクを最小化します。検証済みベストプラクティスに基づくリファレンスアーキテクチャ

本リファレンスアーキテクチャは、検証済みベストプラクティスを体系化した設計指針として、お客様が実装・展開に直接活用できる実践的なフレームワークです。多様なアプリケーションに対応するナレッジベースとして機能するとともに、標準化と再現性を担保し、スケーラブルなAI基盤の構築を支援します。

Grace

大規模コンピューティング 〉

BlackwellHGXプラットフォーム

AIの訓練と推論のためのハイパースケールGPUコンピューティング 〉MGXプラットフォーム

スケーラブルなコンピューティングに対応する汎用基盤 〉大規模コンピューティング

ASUS AI POD ― 次世代AIインフラを支える超高密度AI基盤

NVIDIA GB200/GB300 NVL72 による圧倒的な計算性能と効率性

ASUSの先進的な AI POD は、NVIDIA GB200/GB300 NVL72ラックに最適化され、

NVIDIA Quantum InfiniBand または NVIDIA Spectrum-X Ethernet ネットワーキングを組み合わせることで、

次世代AIクラスタ向けの極めて高い拡張性・性能を実現します。

液冷対応構成では、

8ラック合計 576 GPU を完全ノンブロッキングで接続する大規模クラスターを構築可能。

空冷構成では、1ラックあたり 72 GPU をサポートし、導入環境に応じて柔軟に選択できます。

■ 特長

NVL72 ベースの超高密度AIアーキテクチャ

液冷/空冷の柔軟なサーマルソリューション

Quantum InfiniBand / Spectrum-X Ethernet による高帯域ネットワーク

576 GPUクラスタを見据えた大規模AI処理に最適

推論・学習の両面で圧倒的な効率と性能を実現

この超高密度・高効率のASUS AI PODは、AI推論・AI開発における計算性能とエネルギー効率を新たなレベルへと引き上げます。AIの訓練と推論のための

ハイパースケールGPUコンピューティングASUS最適化 NVIDIA HGX™ リファレンスアーキテクチャ

AIファインチューニング・LLM推論・学習における最高クラスの効率性とGPU密度を実現

ASUS が最適化した NVIDIA HGX™ リファレンスアーキテクチャは、AIファインチューニング、LLM推論、モデル学習において、比類ない 効率性・熱設計・GPU密度 を提供します。

本ソリューションは、

NVIDIA HGX™ B300 を搭載した ASUS XA NB3I-E12

NVIDIA HGX™ B200 を搭載した ESC NB8-E11

をベースとした集中型ラック構成で、液冷・空冷いずれのラックシステムにも対応する 圧倒的な製造キャパシティ を備えています。

■ 主な特長

●最高効率のHGXリファレンス設計:ASUS独自の最適化により高いGPU密度と均一な熱管理を実現

●高性能AIワークロードに最適化:ファインチューニング、LLM推論、大規模モデル学習に最適

●液冷/空冷両対応:導入環境や運用要件に合わせて柔軟に選択

●大規模製造能力による安定供給:短納期対応・高品質・均一なパフォーマンスを保証

●TCO削減:効率的な冷却、標準化された設計により保守・運用コストを大幅に低減-

NVIDIA HGX™ B300搭載のASUS AI POD

B300LC Quantum Spectrum 対応GPU B300 NVL8 B300 NVL8 フォームファクタ 5RU 5RU ラック/ノード ラックあたり8xノード /9xラック ラックあたり8xノード /4xラック 1 SU 9xラック / 72xノード 4xラック / 32xノード スイッチ(N/S) 8x SN5610 (リーフ)/4x SN5610 (スパイン) 2x SN5610(リーフ) スイッチ (E/W) 8x Q3400-RA(リーフ)/ 4x Q3400-RA(スパイン) 8x SN5610 (リーフ)/4x SN5610 (スパイン) サーバー XA NB3I-E12L XA NB3I-E12L ストレージ RS501A-E12-RS12U RS501A-E12-RS12U MGMT RS700-E12-RS4U RS700-E12-RS4U -

ASUS AI POD with NVIDIA HGX™ B300 AC

B300AC Quantum Spectrum 対応GPU B300 NVL8 B300 NVL8 フォームファクタ 9RU 9RU ラック/ノード 4x Node per Rack / 18x rack 4x Node per Rack / 8x rack 1 SU 18x rack / 72x node 8x rack / 32x Node スイッチ (N/S) 8x SN5610 (リーフ)/4x SN5610 (スパイン) 2x SN5610 (Leaf) スイッチ (E/W) 8x Q3400-RA (Leaf) / 4x Q3400-RA (Spine) 8x SN5610 (リーフ)/4x SN5610 (スパイン) Server XA NB3I-E12 XA NB3I-E12 Storage RS501A-E12-RS12U RS501A-E12-RS12U MGMT RS700-E12-RS4U RS700-E12-RS4U -

ASUS AI POD with NVIDIA HGX™ B200

B200AC Quantum Spectrum 対応GPU B200 NVL8 B200 NVL8 フォームファクタ 10RU 10RU ラック/ノード 4x Node per Rack / 8x rack 4x Node per Rack / 8x rack 1 SU 8x rack / 32x node 8x rack / 32x Node スイッチ (N/S) 2x SN5610 (Leaf) 2x SN5610 (Leaf) スイッチ (E/W) 8x QM9700 (Leaf) / 4x QM9700 (Spine) 4x SN5610 (Leaf) / 2x SN5610 (Spine) Server ESC N8B-E11 ESC N8B-E11 Storage RS501A-E12-RS12U RS501A-E12-RS12U MGMT RS700-E12-RS4U RS700-E12-RS4U

スケーラブルなコンピューティングに対応する汎用基盤

大規模言語モデル(LLM)および没入型ワークロードを支えるスケーラブルな処理性能ASUS NVIDIA MGX準拠ラックソリューション

次世代AIインフラに最適化されたESC8000シリーズ

ASUS は、NVIDIA MGX仕様に準拠した最新ラックソリューションとして ESC8000 シリーズを展開しています。

本シリーズは デュアル Intel® Xeon® 6 プロセッサー、RTX PRO™ 6000 Blackwell Server Edition、さらに最大 800Gb/s を実現する NVIDIA ConnectX-8 SuperNIC を採用し、次世代AIワークロードに求められる 高い演算性能と圧倒的な拡張性 を提供します。

■ 主な特長

●NVIDIA MGX準拠設計:将来のGPU・NICアップグレードにも柔軟に対応

●最大800Gb/sの高スループット:NVIDIA ConnectX-8 SuperNIC により高速かつ低遅延のネットワークを実現

●スケーラブルGPU構成:RTX PRO™ 6000 Blackwell Server Editionをはじめ、多様なGPU構成をサポート

●デュアルXeon 6搭載:最新世代CPUによる高い処理性能とバランスの良いシステム構成

■ NVIDIA AI Enterprise との統合

NVIDIA AI Enterprise ソフトウェアプラットフォームとのシームレスな統合を実現。

AI開発から推論、大規模分散環境まで、フルスタックでスケーラブルなAIインフラとして導入可能です。MGX 4U プラットフォーム搭載のASUS AI POD

MGX CX8 Quantum Spectrum 対応GPU H200 NVL, L40S, RTX Pro 6000 BSE H200 NVL, L40S, RTX Pro 6000 BSE フォームファクタ 4RU 4RU ラック/ノード ラックあたり8xノード / 合計4xラック、またはラックあたり4xノード / 合計8xラック ラックあたり8xノード / 合計4xラック、またはラックあたり4xノード / 合計8xラック 1 SU 8xラック / 4xまたは 8xラック / 32xノード 8xラック / 4xまたは 8xラック / 32xノード スイッチ (N/S) 2x SN5610(リーフ) 2x SN5610(リーフ) スイッチ (E/W) 4x QM9700(リーフ) / 2x QM9700(スパイン) 2x SN5610(リーフ) サーバー ESC8000-E12P

ESC8000A-E13PESC8000-E12P

ESC8000A-E13Pストレージ RS501A-E12-RS12U RS501A-E12-RS12U MGMT RS700-E12-RS4U RS700-E12-RS4U -

-

AIサービスとプラットフォーム開発

ASUSは、データセンターを迅速に立ち上げるだけでなく、導入後のスムーズな運用を継続的に支えることを重視しています。

そのためASUSは、包括的なソフトウェアツールおよびプラットフォーム群を提供しています。

これらは、ワンクリックでデプロイできる機能を備えており、課金システムを含むビジネス要件に合わせて柔軟にカスタマイズ可能です。

お客様の運用形態に最適化されたインターフェースやサービスを構築できる点が大きな特徴です。-

展開および管理プラットフォーム

-

AIDC

自動化された大規模な導入とプロビジョニング

-

ログと監視

フルスタックの可視性とプロアクティブなアラート

-

ACC

サーバー管理の一元化

-

UFM および NMX

スマートファブリック監視とネットワーク最適化

-

-

サービスプラットフォーム

-

AIプラットフォーム

スケーラブルなAIトレーニングおよび推論プラットフォーム

-

HPCスケジューラ

効率的なコンピューティングリソースとジョブオーケストレーション

-

-

-

ASUS AIファクトリーで業界全体にわたるAIトランスフォーメーションを推進

その他の成功事例 〉 -

NVIDIAによる精度: ASUSサーバーがAIトランスフォーメーションを推進

ASUSは、製造業のお客様と連携し、NVIDIA Omniverse と大規模AIを活用した先進的なコンセプトの実現に取り組んでいます。

ASUSは、製造業のお客様と連携し、NVIDIA Omniverse と大規模AIを活用した先進的なコンセプトの実現に取り組んでいます。

NVIDIA HGX および AGX プラットフォームを搭載した ASUS のAIサーバーによって、インテリジェントエージェントが実環境で稼働し、データ収集やエッジでのインサイト処理を行いながら、Omniverse 上のシミュレーションとリアルタイムに同期します。

ASUSが構築するデータセンターは中核となるコンピューティング処理を担い、一方でお客様のロボティクスシステムは NVIDIA AGX 上で動作し、センサーデータの取り込み、エッジ推論、クラウドとの協調をシームレスに統合。これにより、高い信頼性を備えたAIパフォーマンスを実現します。-

ESC8000A-E13P

- AMD Turin CPU

- NVIDIA RTX PRO 6000 x 8

- DIMM 64GB x 8

- NVIDIA CX7 x 3

- 1TB OSドライブ x 2

-

VS320D-RS12

- インテルXeon CPU

- 自動階層化

- DIMM 32GB x 4

- NIC 25G イーサネット4

- SAS HDD 20TB x 12

-

-

ASUSが国家レベルのバイオメディカルAIスーパーコンピュータを後押し、ライフサイエンスの革新に貢献

ASUSは、堅牢なAIHPCプラットフォームと NVIDIA SDK(Software Development Kit)を基盤に、台湾の国家衛生研究院(National Health Research Institutes, NHRI)と提携し、バイオメディカル分野向けのAIスーパーコンピュータを構築しました。

ASUSは、堅牢なAIHPCプラットフォームと NVIDIA SDK(Software Development Kit)を基盤に、台湾の国家衛生研究院(National Health Research Institutes, NHRI)と提携し、バイオメディカル分野向けのAIスーパーコンピュータを構築しました。

この取り組みは、バイオメディカル研究や精密医療における革新的なブレークスルーを生み出し、医療機関が先端AIテクノロジーを活用して生命科学研究を大幅に加速できる環境を実現しています。

ASUSは、AIモデル開発からインフラストラクチャの運用保守、最適化までを一貫して担い、常にシームレスで高性能なAIコンピューティングを提供しています。

本AIスーパーコンピュータは劇的な性能向上を達成しており、ゲノムデータ解析では従来のCPU比で87倍、分子動力学シミュレーションでは9倍、さらにAI画像アノテーションや自然言語処理では最大180〜250倍の高速化を実現しています。-

ESC NB8-E11

- 第4/第5世代インテル® Xeon®スケーラブル・プロセッサーx2

- NVIDIA Blackwell HGX™ B200 x 8

- DIMM x 32, DDR5 5600 RDIMM/ 3DS RDIMM

- NVLink™を介したGPU間のダイレクトインターコネクト

-

VS320D-RS12

- インテルXeon CPU

- 自動階層化

- DIMM 32GB x 4

- NIC 25G イーサネット4

- SAS HDD 20TB x 12

-

-

スマートシティAIプラットフォームによる公共安全とガバナンスの変革

ASUSは、台湾初となるスマートシティ向け「ダイナミック画像AIプラットフォーム」を支えるために、基盤となるAIインフラと高いコンピューティング能力を提供しています。

ASUSは、台湾初となるスマートシティ向け「ダイナミック画像AIプラットフォーム」を支えるために、基盤となるAIインフラと高いコンピューティング能力を提供しています。

ASUSの高性能GPU/CPUサーバー、ストレージソリューション、そして統合的なサービス管理を活用することで、自治体向けにデータを一元化し、AIによる高度なインサイトを提供できる環境を実現しています。

プラットフォームで収集した重要情報は、シームレスなスマートシティダッシュボード上に集約。

そこでは、交通量解析、ヒートマップ表示、ソーシャルディスタンス管理やマスク着用検出などの情報が一目で把握できます。

さらに、KVM ベースのサービスプラットフォームと、CNCF認定の Kubernetes を採用することで、AIのトレーニング、推論処理、コンテナサービスを効率的に運用できる体制を整えています。

この取り組みにより、公共の安全性向上、交通最適化、データドリブンな行政運営の推進、そしてコスト効率の改善とともに、スマートシティにおけるイノベーション創出を後押ししています。-

ESC8000A-E13P

- AMD Turin CPU

- NVIDIA RTX PRO 6000 x 8

- DIMM 64GB x 8

- NVIDIA CX7 x 3

- 1TB OSドライブ x 2

-

VSD320D-RS26

- インテルXeon CPU

- 自動階層化

- DIMM 32GB x 4

- NIC 25G イーサネット4

- SAS SSD 15.36TB x 26

-

-

-

ASUSのメリットとサービス

信頼できる NVIDIA® Omniverse 統合プロバイダとして、ASUS は戦略コンサルティングから導入サポートまで包括的なソリューションを提供し、産業デジタル化の可能性を最大限に引き出すお手伝いをします。

統合コンサルティングカスタマイズされたデジタルトランスフォーメーションの構想技術教育専門的なOmniverseのスキルトレーニング導入サポートシームレスなシステム統合と実装カスタムソリューション特定のニーズに合わせたアプリケーション開発

-

よくあるご質問

-

ASUSとパートナー企業と共にイノベーションを加速 AI主導の成功のきっかけに

-

-

GB200 NVL72 Quantum Quantum Quantum Spectrum 対応GPU GB200 GB300 GB300 フォームファクタ 48RU 48RU 48RU ラック/ノード 18xコンピューティングトレイ/ 9xスイッチトレイ 18xコンピューティングトレイ/ 9xスイッチトレイ 18xコンピューティングトレイ/ 9xスイッチトレイ 1 SU 16xラック/288xノード 16xラック/288xノード 16xラック/288xノード スイッチ (N/S) 8x SN5610(リーフ)/4x SN5610 (スパイン)/4x SN5610 (コア) 8x SN5610 (リーフ)/4x SN5610 (スパイン) 8x SN5610 (リーフ)/4x SN5610 (スパイン) スイッチ (E/W) 16x Q9700(リーフ)/18x Q9700(スパイン) 16x Q3400-RA(リーフ)/9x Q3400-RA(スパイン) 16x Q3400-RA(リーフ)/9x Q3400-RA(スパイン) サーバー ESC NM2N721-E1 XA GB721-E2 XA GB721-E2 ストレージ RS501A-E12-RS12U RS501A-E12-RS12U RS501A-E12-RS12U MGMT RS700-E12-RS4U RS700-E12-RS4U RS700-E12-RS4U -

ASUS AI WEKAストレージリファレンス

管理ノード仕様(WMS)

- サーバーまたは VM は次の要件を満たしている必要があります。

- ブートドライバ:同一のブートドライブを2台搭載したシステムでは、OSはミラーリングされたパーティション(LVM)にインストールされ、使用可能容量は最低141GBです。

- コア数とRAM:最低4コア、最低16GB RAM

- ネットワークインターフェイス:最低1Gbps

GBシリーズ Bシリーズ MGX/HGXシリーズ サーバーモデル ASUS RS501A-E12-RS12U CPUおよびメモリ AMD 64C ( 9005シリーズ ) および 768G RAM ネットワーク 400G(200x2) IB NIC x 2 ストレージ ブートディスク:2 x 960G NVMe M.2

ストレージディスク : 16 x 30.72 TLC NVMe U.2サーバーノード 27 19 8 使用可能容量 10PB 7PB 2.2PB 読み取り速度 2284GB 1607GB 676GB 書き込み速度 691GB 486GB 164GB 読み取りIOPS 49.5 Million 34.8 Million 14.6 Million 書き込みIOPS 12.4 Million 8.7 Million 3.6 Million ストライプ幅 16+2+1 16+2+1 5+2+1 WEKAデータプラットフォーム認定

-

ネットワークトポロジー

NVIDIA GB200 NVL72のパフォーマンスには、効率的で高帯域幅のネットワーク接続が不可欠です。以下は、複数のNVL72システムを接続し、より大規模なネットワークインフラストラクチャに統合するために使用される一般的な外部ネットワークアーキテクチャとテクノロジの概要です。

NVIDIA Quantum-2 QM9700シリーズInfiniBandスイッチ

ODs 1 1 2 4 ラック 1 2 4 8 6 32 64 コンピューティングトレイ 18 36 72 144 288 576 1152 Blackwell GPU 72 144 288 576 1152 2304 4608 Bluefield-3 (DPU) 32 72 144 288 576 1152 2304 スイッチ スパインスイッチ数 0 2 4 8 16 32 リーフスイッチ数 2 4 8 16 32 64 -

液冷ソリューション

ASUSはパートナー企業と連携し、キャビネットレベルの包括的な水冷ソリューションを提供しています。CPU/GPUコールドプレート、冷却分配ユニット、冷却タワーなど、データセンターにおける消費電力を最小限に抑え、電力使用効率(PUE)を最適化するよう設計された包括的なソリューションです。

空冷ソリューション

コンパクトな設備を備えた小規模データセンターに最適です。

既存の空冷式データセンターのニーズを満たし、現在のインフラストラクチャと簡単に統合できるように設計されています。

すぐに実装および展開したい企業に最適です。液冷ソリューション

大規模で高負荷のインフラストラクチャに最適です。

長期間にわたってエネルギー効率を維持し、低PUEを実現します。

TCOを削減し、最大限の価値と費用対効果の高い運用を実現します。